آیا این اسکن آیفون است ؟ آیا اپل سعی می کند از وارد شدن اطلاعات شخصی شما جلوگیری کند ؟

هفته پیش ، این کمپانی عملکرد آینده iOS 15 را برای جلوگیری از تصاویر آنلاین سوء استفاده جنسی از کودکان معرفی کرد . این ( اعلامیه ) بلافاصله جنجال برانگیخت زیرا سیستم برای تشخیص محتوای غیرقانونی ذخیره شده در حساب iCloud Photos ، روی پردازش " روی دستگاه " آیفون ضربه می زند .

کلمه " اسکن آیفون " خبرساز شد ، اما به گفته اپل ، این عبارت مزایای واقعی حریم خصوصی پردازش روی دستگاه را تحت الشعاع قرار می دهد .

روز دوشنبه ، اریک نونشواندر ، مدیر حریم خصوصی کاربران شرکت ، یک جلسه مطبوعاتی برای شفاف سازی برگزار کرد . به گفته وی ، رویکرد اپل به عنوان اسکن ، سنتی نیست ، جایی که سرورهای شرکت همه فایل های موجود در آیفون را مشاهده کرده و محتویات آنها را یاد می گیرند .

در عوض ، این شرکت از پردازش روی دستگاه برای ایجاد یک گزارش استفاده می کند . یک آیفون اساساً عکس بارگذاری شده را با پایگاه داده ملی فهرست بندی شده از سوء استفاده جنسی از کودکان (CSAM) مقایسه می کند . سپس دستگاه یک "کوپن ایمنی" رمزنگاری در مورد اینکه آیا تصویر با یک فایل CSAM شناخته شده که در اینترنت در حال گردش است مطابقت دارد ، ایجاد می کند .

سپس کوپن بر روی سرورهای اپل ذخیره می شود . با این حال ، خود کوپن محتویات فایل تصویر را نشان نمی دهد . اپل تنها در صورتی می تواند کوپن را رمزگشایی کند که حساب iCloud آستانه مشکوک بودن CSAM را پشت سر گذاشته باشد .

گیج کننده ، اما کمتر تهاجمی ؟

درک این رویکرد دقیقاً آسان نیست اما به گفته اپل ، این سیستم بسیار تهاجمی تر از آن چیزی است که سیستم های تشخیص تصاویر جنسی کودکان موجود برای پلتفرم های ذخیره سازی ایمیل و ابر انجام می دهند ، که می تواند شامل اسکن بی رویه هر تصویر در حساب کاربر باشد . در عوض ، اپل در تلاش است لایه ای از حریم خصوصی ایجاد کند که مانع از یادگیری این شرکت در مورد فایل های تصویری شما شود ، اما برای انجام این کار نیاز به پردازش روی دستگاه است .

پردازش روی دستگاه باعث شده است که محققان امنیتی و رئیس واتساپ زنگ خطر را در مورد اصطلاحاً اسکن به صدا در آورند ، و هشدار داد که ممکن است از سیستم مشابه برای نظارت گسترده بر سخت افزار شخصی افراد سوء استفاده شود . با این حال ، اپل می گوید اصطلاح " اسکن روی دستگاه " فناوری نادرستی را نشان می دهد .

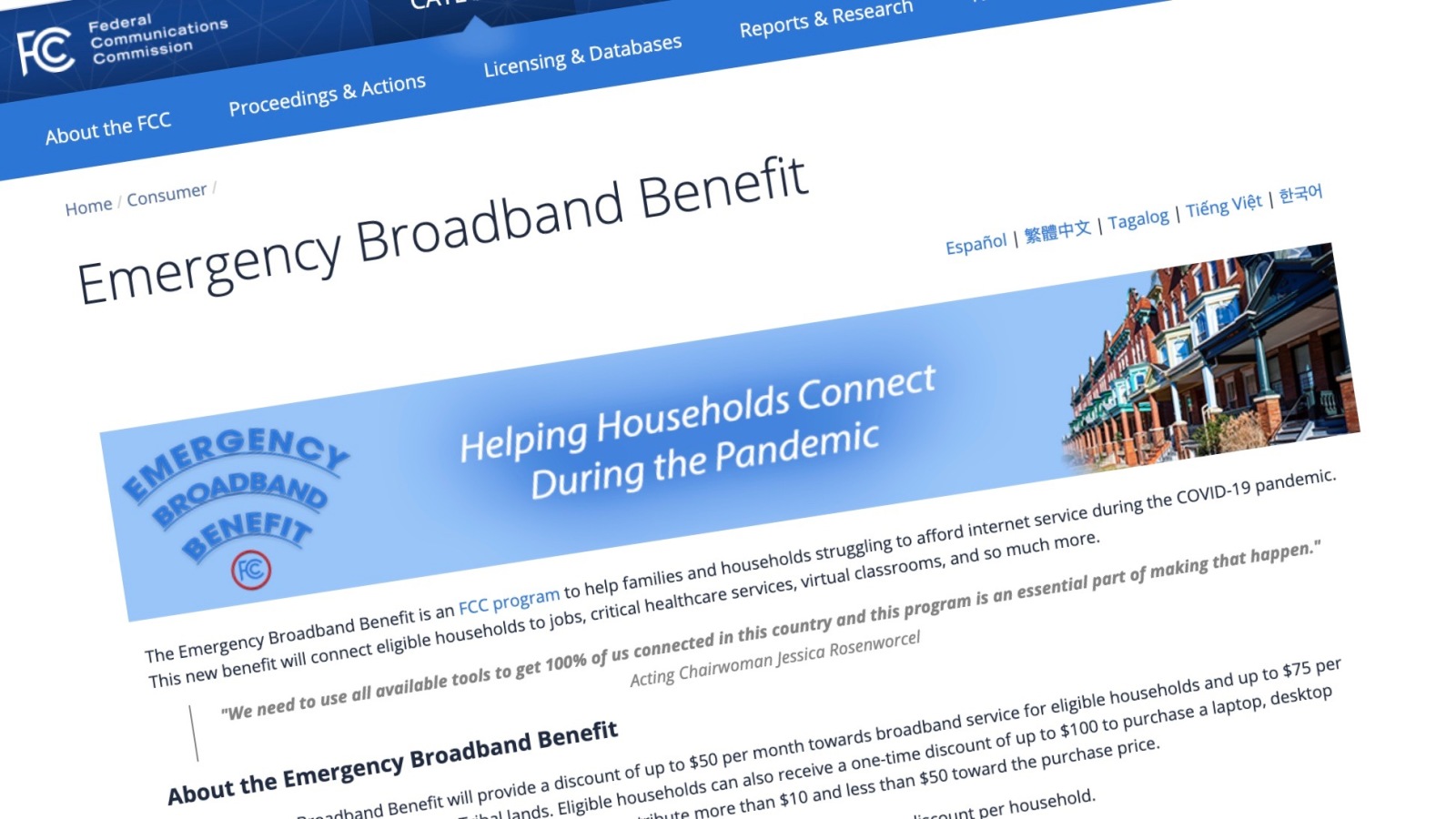

این شرکت افزود که رویکردهای دیگر برای اسکن CSAM در بسترهای ابری معمولاً مات هستند و باید همه تصاویر را مشاهده کنند . از سوی دیگر ، اپل قصد دارد الگوریتم های تشخیص CSAM خود را برای محققان امنیتی باز کند . در جریان جلسه مطبوعاتی ، اپل همچنین تأکید کرد که انتظار دارد سیستم آینده در کمک به مجریان قانون برای جلوگیری از شکارچیان جنسی کودک ، تغییری ایجاد کند .

سیستم CSAM اولین بار پس از راه اندازی iOS 15 در پاییز در ایالات متحده مستقر می شود . چه زمانی یا اگر کوپرتینو سیستم را به سایر کشورها گسترش می دهد ، ناگفته باقی ماند . پس از ورود سیستم ، کوپن های ایمنی برای عکس هایی که قبلاً در iCloud Photos ذخیره شده اند ایجاد می شود .

اگر طرفدار آن نیستید ، اپل می گوید کاربر می تواند به سادگی iCloud Photos را در آیفون غیرفعال کند. پردازش روی دستگاه ، برنامه Photos یا سایر فایل های تصویری ذخیره شده در دستگاه را پوشش نمی دهد . این شرکت همچنین قول داده است که هرگز به دولتها اجازه دسترسی به این سیستم را ندهد .

منبع : pcmag